(AI502) 5. regularization2

본 포스팅은 AI502수업에서 제가 새로 알게 된 부분만 정리한 것입니다.

Bagging

- training data를 ramdom-sampling해서 model을 각각 학습시키고, averaging하거나 voting한다.

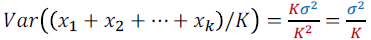

- smaller variance

Dropout

- 대부분의 sub-network는 학습이 되지 않는다.

- fast approximation

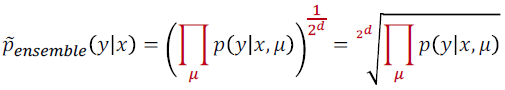

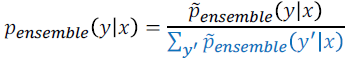

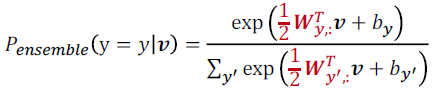

- geometric mean

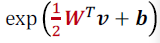

- maxout activation과 같이쓰면, 각 유닛은 비슷하게 학습된다.

- 장점

- effective 성능

- computationally cheap

- dropout은 distributed representation을 쓰는 어떤 모델과도 잘 어울린다.

- co-adaptation 피함

- 몇몇 뉴런이 다른 뉴런에 dependent 해지는 것

-

sparse activations

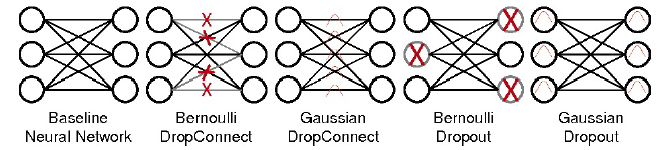

- Drop connect

- Gaussian Dropout

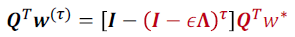

- dropout을 generalize하는 방법으로는 noise injection을 하는 방법이 있다.

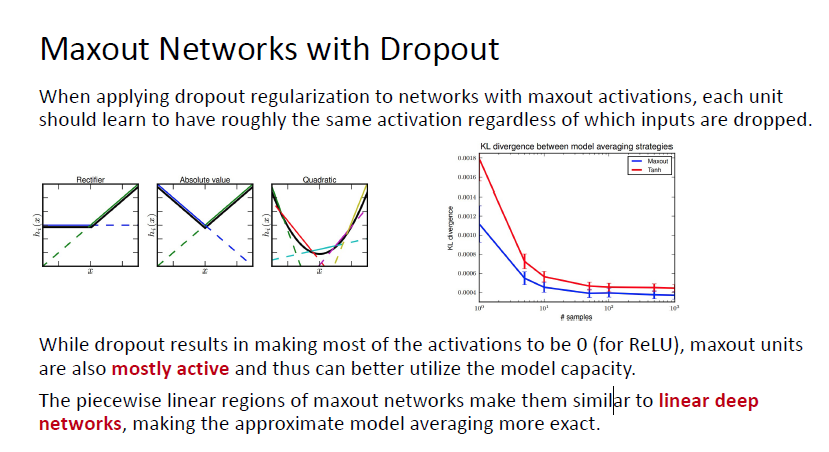

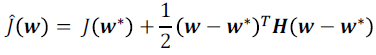

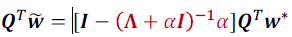

Early Stopping = L2-Regularization

- Early Stopping

- L2 Regularization

- $\epsilon, \alpha, \tau$를 잘 골라서 두 식을 갖게 만들 수 있다.

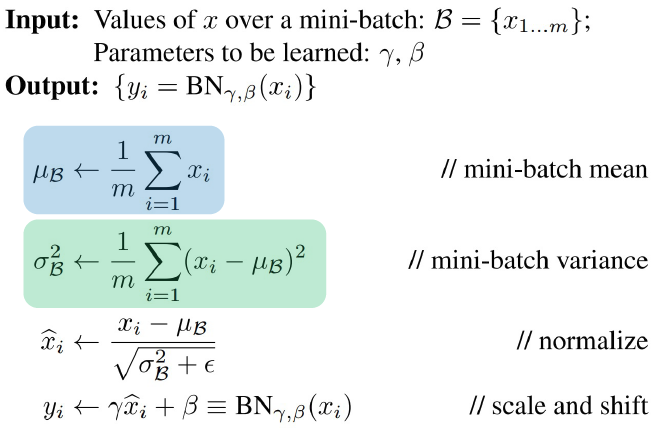

Batch Normalization

- internal covariate shift problem 해소

- generalization 성능 향상, converge 더 빨리

- learning rate에 덜 sensitive함

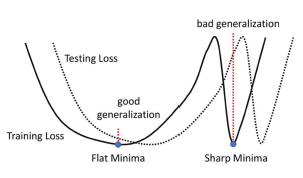

- loss surface를 더 smoother

- perturbation에 덜 sensitive, more predictable gradient

Weight Tying (Parameter Sharing)

- 같은 Conv filter 사용, RNN에서 같은 weight 사용하는 것

Data Augmentation

- input이나 hidden unit에 noise 추가